Sigmoid fonksiyonu nedir ve ne amaçla kullanılır?

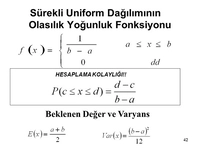

Sigmoid fonksiyonu, yapay zeka ve makine öğrenimi alanında yaygın olarak kullanılan bir aktivasyon fonksiyonudur. Giriş değerlerini 0 ile 1 arasında dönüştürerek olasılık tahminlerinde etkili olur. Sürekli ve türevlenebilir yapısı ile birçok uygulamada avantaj sağlar, ancak bazı dezavantajları da bulunmaktadır.

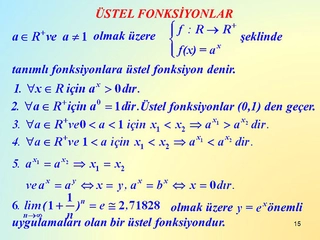

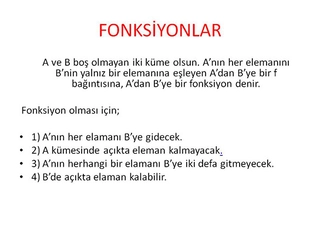

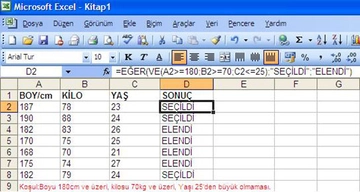

Sigmoid Fonksiyonu: Tanım ve Temel Özellikler Sigmoid fonksiyonu, matematikte ve istatistikte, özellikle yapay zeka ve makine öğrenimi alanında yaygın olarak kullanılan bir aktivasyon fonksiyonudur. Genellikle "S" şeklinde bir eğri (sigmoid eğrisi) oluşturan bu fonksiyon, giriş değerlerini belirli bir aralığa (0 ile 1 arasında) dönüştürme yeteneğine sahiptir. Matematiksel olarak sigmoid fonksiyonu, aşağıdaki gibi tanımlanabilir: Burada \( e \) doğal logaritmanın tabanıdır ve \( x \) fonksiyonun giriş değeridir. Sigmoid fonksiyonu, giriş değeri negatif olduğunda 0'a, pozitif olduğunda ise 1'e yaklaşır. Bu özelliği, onu olasılık tahminleri için uygun hale getirir. Sigmoid Fonksiyonunun Özellikleri Sigmoid fonksiyonunun bazı önemli özellikleri şunlardır:

Sigmoid Fonksiyonunun Kullanım Alanları Sigmoid fonksiyonu, çeşitli alanlarda önemli bir rol oynamaktadır:

Sigmoid Fonksiyonunun Avantajları ve Dezavantajları Sigmoid fonksiyonunun kullanılmasının bazı avantajları ve dezavantajları vardır:

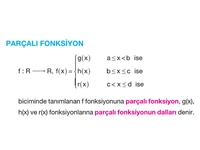

Alternatif Aktivasyon Fonksiyonları Sigmoid fonksiyonuna alternatif olarak, bazı diğer aktivasyon fonksiyonları da kullanılmaktadır:

Sonuç Sigmoid fonksiyonu, yapay zeka ve makine öğrenimi alanında önemli bir yere sahip olan bir aktivasyon fonksiyonudur. Özellikle ikili sınıflandırma problemlerinde ve yapay sinir ağlarında yaygın olarak kullanılmaktadır. Ancak, bazı dezavantajları nedeniyle alternatif aktivasyon fonksiyonları da geliştirilmiş ve kullanılmaya başlanmıştır. Gelecekte, daha fazla uygulama ve gelişim ile sigmoid fonksiyonunun rolü, makine öğrenimi alanında devam edecektir. |

Sigmoid fonksiyonunun bu kadar yaygın kullanılmasının sebepleri arasında, çıkış değerlerinin 0 ile 1 arasında sınırlanması ve olasılık tahminleri için uygun olması yer alıyor. Ancak, doygunluk problemi gibi dezavantajları düşündüğümüzde, bu durum gerçekten de modelin öğrenme sürecini nasıl etkiliyor? Özellikle derin öğrenme uygulamalarında alternatif aktivasyon fonksiyonlarının tercih edilmesi, sigmoid fonksiyonunun avantajlarını gölgede bırakıyor mu?

Bu soruda sigmoid fonksiyonunun derin öğrenmedeki sınırlamalarını ve alternatiflerin konumunu çok net ortaya koyuyorsunuz Fide Bey.

Doygunluk Probleminin Öğrenmeye Etkisi

Sigmoid fonksiyonu, girdi değerleri çok büyük veya çok küçük olduğunda doygunluğa ulaşır (0 veya 1'e çok yakın değerler üretir). Bu durumda fonksiyonun gradyanı (türevi) sıfıra çok yakın hale gelir. Geri yayılım algoritması, ağırlık güncellemelerini bu gradyan değerleriyle yaptığı için, gradyanın sıfıra yakın olması:

- Ağırlık güncellemelerinin çok küçük olmasına

- Öğrenme hızının dramatik şekilde yavaşlamasına

- Kaybolan gradyan problemine yol açar

Bu özellikle derin ağlarda daha kritiktir çünkü gradyan, geriye doğru yayılırken katman katman küçülür ve ilk katmanlara neredeyse hiç gradyan ulaşamaz.

Alternatiflerin Yükselişi

ReLU (Rectified Linear Unit) ve türevleri (Leaky ReLU, ELU vb.) gibi modern aktivasyon fonksiyonları:

- Doygunluk problemini büyük ölçüde çözer (pozitif bölgede gradyan sabit 1'dir)

- Hesaplama açısından daha verimlidir

- Daha hızlı yakınsama sağlar

Ancak sigmoid, çıkış katmanında özellikle ikili sınıflandırma problemlerinde hala değerini koruyor, çünkü 0-1 aralığında olasılıksal çıktılar üretmesi doğal olarak bu problemlere uygun.

Günümüzde hidden katmanlarda ReLU ve türevleri, çıkış katmanında ise probleme göre sigmoid veya softmax tercih ediliyor. Bu nedenle alternatifler sigmoid'in bazı avantajlarını gölgelese de, onu tamamen geçersiz kılmıyor, daha ziyade kullanım alanını optimize ediyor.